Hiter vodnik za pisanje datoteke Robots.txt

Kako se posvetujete z ogromnim učbenikom? Prebiranje indeksa. No: obstaja en element, ki je pravi povzetek vašega spletnega mesta ...

Edini način, da stopite v stik s pajkom iskalnika ali gosenicah, je prek datoteke, imenovane Robots.txt. Ali bolje. Ko Googlu pošljete predlog spletnega mesta, se sooči s preprosto ogromno količino informacij.

Kako pregledati tako velik učbenik, da se vam zdi, da nikoli ne boste našli vsega, kar potrebujete? Posvetujete se namig. No: datoteka robots.txt je indeks vašega spletnega mesta.

To je dokument, ki ga je enostavno izpolniti in pajku iskalnika pove, kaj naj išče. Na kratko: pomagali mu boste razumeti, iz česa je sestavljeno vaše spletno mesto, tako da vam bo algoritem lahko dal uvrstitev, ki je skladna z delom, ki ste ga opravili.

Ali lahko kdo napiše datoteko robots.txt?

Kratek odgovor je da. Iskren odgovor je ne. Čeprav je slovnica datoteke robots.txt izjemno preprosta in je njena sestava sestavljena iz nekaj vrstic, se je bolje zanesti na skrb izkušenega spletnega skrbnika, ki ve, kam dati roke. Navsezadnje je majhna napaka dovolj, da ogrozi pozicioniranje vašega spletnega mesta in zato zaustavi vse operacije SEO, še preden se začnejo.

Preden začnete, vedite eno stvar: kdorkoli si lahko ogleda datoteko robots.txt katerega koli mesta, tako da za domeno napiše /robots.txt. Lahko se celo posvetujete z Googlom!

Takšno datoteko lahko napišete brez nalaganja posebne programske opreme. Pravzaprav je dovolj, da uporabite svojo beležko in shranite, uganite kaj, v formatu .txt.

Skupaj napišimo robots.txt: glavo

Začnimo od začetka, kot je vedno logično. Odpiranje datoteke, oziroma glava, je v celoti posvečena imenu pajka, pred njim pa majhen napis, ki je vedno enak. Recimo, da želite, da vas Google opazi. Torej bo prva vrstica:

Uporabniški agent: Googlebot

Ta zelo kratek niz sporoča Googlu, da ga bo vse, kar sledi, zagotovo zanimalo. Če želite, da vsi pajki, ki berejo to vrsto datoteke, lahko pregledajo dokument, zamenjajte Googlebota s preprosto *, a zvezdica.

Zdaj, ko ste navedli, kateri pajek, tj. KDO, boste morali navesti tudi KAJ bo moral brati.

Vsaka vrstica kode po definiciji ustreza dejanju stroja. Samoumevno je, da vsak ukaz v datoteki robots.txt ustreza temu, česar stroj ne bi smel narediti. In to je ključ, ki vam omogoča, da napišete res učinkovito. Govorimo o ukazu DISALLOW.

Kaj je ukaz DISALLOW?

Il onemogoči ukaz omogoča sklepanje z izključevanjem. Z drugimi besedami, ko se reče, da je treba najprej povedati, česa se ne bi smelo narediti – no, sklepate z izključevanjem. Poleg prepovedi obstaja tudi dovolitev, ki je izjema od blokade.

Če želite napisati dobro robotsko datoteko, boste morali razmišljati obratno, torej boste morali Googlu povedati, česa ne sme brati. Če pišete:

Disallow:

Pajek bo prebral vaše celotno spletno mesto, brez zavor.

Če za “Disallow:” vstavite poševnico (torej Disallow: /), stran ne bo vpisana v iskalnike, pika.

Disallow: /imeniki/

Zamenjajte besedni imenik z mapo, za katero želite, da je zavrnjen v pajkovem pogledu. Enako lahko storite z določeno datoteko.

Prepovedano: /myfile.html

POZOR na ločila in črke, velike ali male črke. Ta vrsta datoteke zelo ceni tovrstne "malenkosti", vendar naredijo veliko razliko.

Zakaj bi Googlu preprečili, da bi prebral velik del vašega spletnega mesta? Ko pišete datoteko te vrste, je pomembno razumeti, katere datoteke se ne smejo pojaviti v iskalniku, vendar brez zlorabe. Vedite pa, da bo vsak, ki pozna točen naslov te določene datoteke, lahko dostopal do nje v vsakem primeru.

Kaj je ukaz DOVOLI?

V datoteko lahko dodate izjemo z ukazom DOVOLJ. Slovnica je enaka, vendar bo ustvarila nekaj izjem od DISALLOW, ki bodo pajku omogočile zanimive možnosti raziskovanja.

Majhna vzorčna datoteka:

Uporabniški agent: Googlebot

Disallow: /slike/

Dovoli: /images/holidays.jpg

V bistvu smo Googlebotu rekli, naj ne upošteva mape s slikami, razen določene fotografije v njej, in sicer tiste s počitnic.

In to je to, fantje. Napisali smo prvo datoteko robots.txt. Seveda, kar bomo naredili za dejansko spletno mesto, bo morda nekoliko drugačno, vendar ne veliko. Če ste v dvomih, vedno poiščite nasvet specializiranega spletnega skrbnika. Svetujemo vam, da ga najprej poskusite napisati sami in mu ga pošljete v pregled, da bo osvojil osnove in bolje razumel delovanje vaše strani.

Kakšna je povezava med robots.txt in zemljevidi spletnih mest?

Zemljevid spletnega mesta je datoteka, ki jo ustvarijo posebni vtičniki in vsebuje vse povezave na spletnem mestu. Ko pajek vstopi na spletno mesto, najprej prebere robote, nato preišče spletno mesto. Če robot med iskanjem najde naslov zemljevida spletnega mesta, bo celoten postopek veliko lažji.

Zgornji kodi dodajte naslednje:

Zemljevid spletnega mesta: http://www.ilnomedeltuositobellissimo.com/sitemap.xml

V zaključku

Vse datoteke robotov so enake. To pomeni, da bo datoteka Robots, napisana za Google, dobro delovala tudi za Bing in sledi isti slovnici.

Dobro organizirana datoteka robots.txt vam omogoča prihranite čas pajka. Naj vas ne obupa: to je prvi korak k uspehu!

Morda vas bo zanimalo tudi:

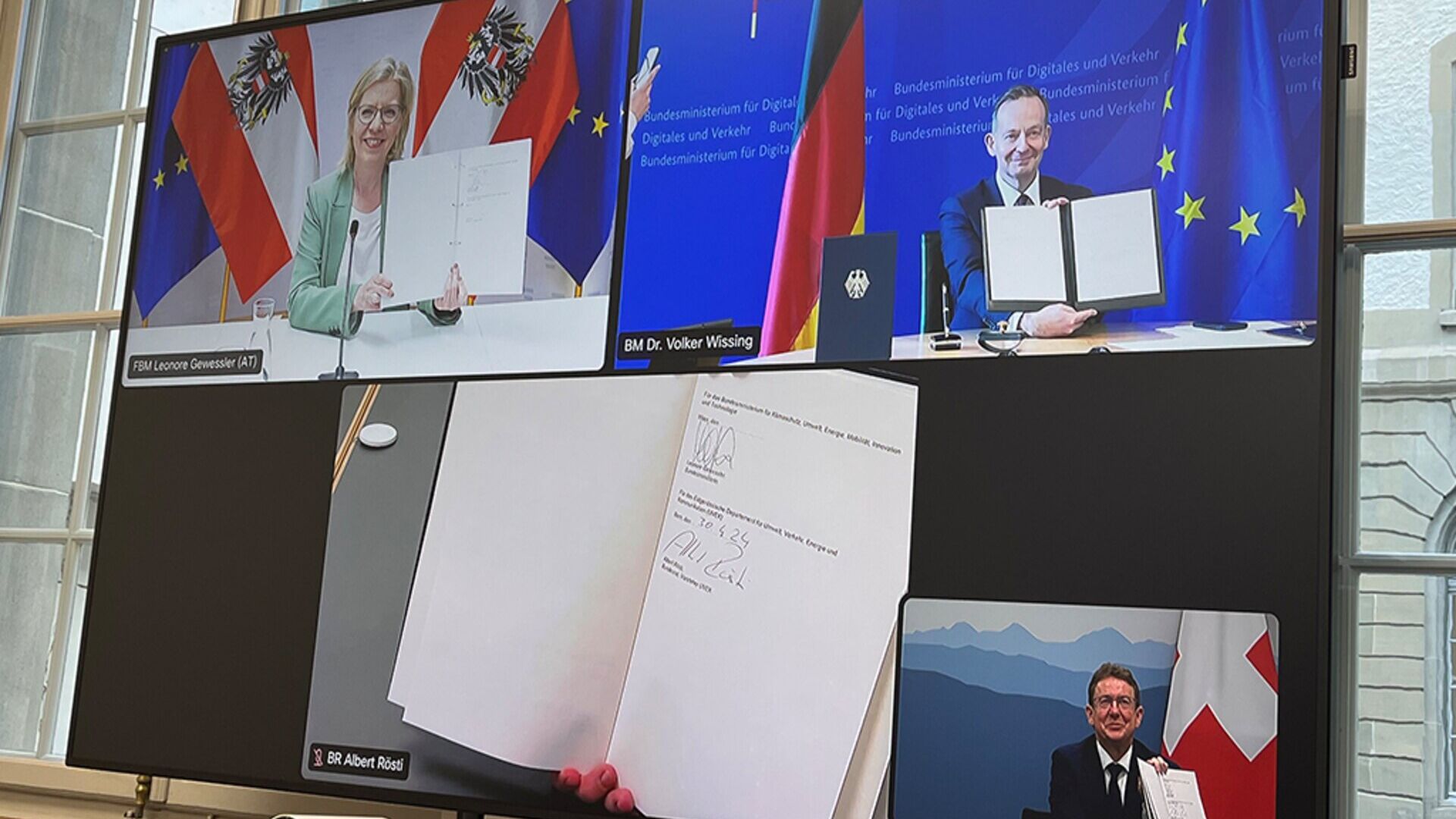

Avstrija, Nemčija in Švica za "inovativnejše" tovorne železnice

Ministri DACH Leonore Gewessler, Volker Wissing in Albert Rösti: uvedba digitalnega samodejnega združevanja je ključni element

Prepričevanje ali manipulacija? Geneza in zgodovinski vpliv PR

Tako odnosi z javnostmi, od sofističnega dialoga stare Grčije do sedanje digitalne dobe, še naprej ponujajo stalne inovacije

avtorja Francesca CaonGeneralni direktor CAON Public Relations

Mladi in kriptovalute: kako izvedeti več o Bitcoinu…

Seznanitev otrok z digitalnimi valutami in verigo blokov je lahko vznemirljiv podvig, glede na njihovo naklonjenost tehnologiji in inovacijam

“Bolnik v središču”: veliko upanje in srečanje v senatu

O pomenu inovacij na področju medicinskih pripomočkov za evropsko zdravstvo bodo 15. maja v Rimu razpravljali strokovnjaki in politiki.

avtorja Alberto NicoliniUrednik Districtbiomedicale.it, BioMed News in Radio Pico